大規模言語モデル (LLM): 2023 年の完全ガイド

LLM について知っておくべきことすべて

概要

Google や Alexa があなたを「理解」しているように見えて驚いて頭をかいたことがありますか? それとも、コンピューターで生成された不気味な人間臭さを感じるエッセイを読んでいることに気づきましたか? あなたは一人じゃない。 カーテンを引いてその秘密、つまり大規模言語モデル (LLM) を明らかにする時が来ました。

これらは何ですか? LLM を隠れたウィザードと考えてください。 彼らは私たちのデジタルチャットを強化し、私たちの混乱したフレーズを理解し、私たちと同じように文章を書くことさえします。 彼らは私たちの生活を変え、SF を現実にしています。

このガイドは LLM のすべてについて説明しています。 何ができるのか、何ができないのか、そしてどこで使われるのかを見ていきます。 それらが私たち全員にどのような影響を与えるかを、平易な言葉で検証していきます。

それでは、LLM へのエキサイティングな旅を始めましょう。

このガイドは誰のためのものですか?

この広範なガイドの対象は次のとおりです。

- 大量のデータを定期的に処理しているすべての起業家やソロプレナー

- AIと機械学習、またはプロセス最適化手法を使い始めている専門家

- AIモジュールまたはAI駆動型製品の市場投入までの時間を短縮することを目的としたプロジェクトマネージャー

- そして、AIプロセスに関係するレイヤーの詳細を知りたい技術愛好家。

大規模言語モデルとは何ですか?

Large Language Model (LLM) は、人間のようなテキストを処理、理解、生成するように設計された高度な人工知能 (AI) システムです。 これらは深層学習技術に基づいており、通常、Web サイト、書籍、記事などのさまざまなソースからの数十億の単語を含む大規模なデータセットでトレーニングされています。 この広範なトレーニングにより、LLM は言語、文法、文脈、さらには一般知識のいくつかの側面のニュアンスを把握できるようになります。

OpenAI の GPT-3 などの一部の人気のある LLM は、トランスフォーマーと呼ばれる一種のニューラル ネットワークを採用しており、これにより複雑な言語タスクを優れた熟練度で処理できるようになります。 これらのモデルは、次のような幅広いタスクを実行できます。

- 質問に答える

- テキストの要約

- 言語の翻訳

- コンテンツの生成

- ユーザーとのインタラクティブな会話にも参加可能

LLM は進化し続けるため、顧客サービスやコンテンツ作成から教育や研究に至るまで、業界全体のさまざまなアプリケーションを強化および自動化する大きな可能性を秘めています。 しかし、それらはまた、偏見のある行動や誤用などの倫理的および社会的懸念も引き起こしており、テクノロジーの進歩に伴い対処する必要があります。

LLM データ コーパスの構築における重要な要素

言語モデルを適切にトレーニングするには、包括的なデータ コーパスを構築する必要があります。このプロセスには、膨大なデータを収集し、その高品質と関連性を確保することが含まれます。言語モデルのトレーニング用の効果的なデータ ライブラリの開発に大きな影響を与える重要な側面を見てみましょう。

データ量とともにデータ品質を優先する

大規模なデータセットは言語モデルをトレーニングするための基礎です。それでも、データ品質には多くの重要性が伴います。広範ではあるが構造化が不十分なデータに基づいてトレーニングされたモデルは、不正確な結果をもたらす可能性があります。

逆に、小規模で細心の注意を払って厳選されたデータセットは、優れたパフォーマンスにつながることがよくあります。この現実は、データ収集に対するバランスの取れたアプローチの重要性を示しています。代表的で多様性があり、モデルの意図した範囲に関連するデータには、入念な選択、クリーニング、整理が必要です。

適切なデータソースの選択

データ ソースの選択は、モデルの特定のアプリケーションの目標に合わせて行う必要があります。

- 対話を生成するモデルは、会話やインタビューなどの情報源から利益を得ることができ、非常に貴重です。

- コード生成に重点を置いたモデルは、十分に文書化されたコード リポジトリから恩恵を受けるでしょう。

- 文学作品や脚本は、創造的な文章を書くことを目指す人に豊富なトレーニング資料を提供します。

対象とする言語とトピックにわたるデータを含める必要があります。これは、指定されたドメイン内で効果的に実行されるようにモデルを調整するのに役立ちます。

合成データ生成を使用する

合成データを使用してデータセットを強化すると、ギャップを埋めて範囲を拡張できます。データ拡張、テキスト生成モデル、ルールベースの生成を使用して、現実世界のパターンを反映する人工データを作成できます。この戦略により、トレーニング セットの多様性が広がり、モデルの復元力が強化され、バイアスが軽減されます。

合成データがターゲット ドメイン内で言語を理解して生成するモデルの能力にプラスに寄与するように、合成データの品質を必ず検証してください。

自動データ収集の実装

データ収集プロセスの自動化により、最新の関連データの一貫した統合が容易になります。このアプローチにより、データ取得が合理化され、スケーラビリティが向上し、再現性が促進されます。

Web スクレイピング ツール、API、データ インジェスト フレームワークを使用すると、さまざまなデータセットを効率的に収集できます。これらのツールを微調整して、高品質で関連性の高いデータに焦点を当てることができます。モデルのトレーニング素材を最適化します。これらの自動システムを継続的に監視して、その精度と倫理的整合性を維持する必要があります。

大規模言語モデル (LLM) の構成要素を理解する

LLM の機能と仕組みを完全に理解するには、いくつかの重要な概念を理解しておくことが重要です。 これらには次のものが含まれます。

単語の埋め込み

これは、単語を AI モデルが解釈できる数値形式に変換する実践を指します。 本質的に、単語の埋め込みは AI の言語です。 各単語は、トレーニング データ内のコンテキストに基づいて意味論的な意味をカプセル化する高次元ベクトルとして表されます。 これらのベクトルにより、AI は単語間の関係と類似性を理解できるようになり、モデルの理解力とパフォーマンスが向上します。

注意メカニズム

これらの高度なコンポーネントは、AI モデルが出力を生成する際に、入力テキスト内の特定の要素を他の要素よりも優先するのに役立ちます。 たとえば、さまざまな感情が詰まった文では、注意メカニズムにより、感情を伴う単語に高い重みが与えられる可能性があります。 この戦略により、AI は状況に応じてより正確でニュアンスのある応答を生成できるようになります。

トランスフォーマー

トランスフォーマーは、LLM 研究で広く使用されている高度なタイプのニューラル ネットワーク アーキテクチャを表します。 トランスフォーマーを際立たせているのは、自己注意メカニズムです。 このメカニズムにより、モデルは入力データのすべての部分を順番ではなく同時に重み付けして考慮することができます。 その結果、自然言語処理タスクにおける一般的な課題である、テキスト内の長距離依存関係の処理が改善されました。

微調整

最も高度な LLM であっても、特定のタスクやドメインで優れた性能を発揮するには、ある程度の調整が必要です。 ここで微調整が登場します。最初に大規模なデータセットでモデルをトレーニングした後、より小さく、より具体的なデータセットでモデルをさらに洗練、つまり「微調整」することができます。 このプロセスにより、モデルは一般化された言語理解能力をより特殊なタスクやコンテキストに適応させることができます。

プロンプトエンジニアリング

入力プロンプトは、LLM が出力を生成するための開始点として機能します。 これらのプロンプトを効果的に作成すること (プロンプト エンジニアリングとして知られる手法) は、モデルの応答の品質に大きな影響を与える可能性があります。 これは芸術と科学の融合であり、モデルがプロンプトを解釈し、応答を生成する方法を深く理解する必要があります。

バイアス

LLM はトレーニングの対象となるデータから学習するため、このデータに存在するバイアスがモデルの動作に浸透する可能性があります。 これは、モデルの出力における差別的または不公平な傾向として現れる可能性があります。 これらの偏見に対処し、軽減することは、AI の分野における重要な課題であり、倫理的に健全な LLM を開発する上で重要な側面です。

解釈可能性

LLM の複雑さを考えると、LLM が特定の決定を下したり、特定の出力を生成したりする理由を理解するのは困難な場合があります。 解釈可能性として知られるこの特性は、現在進行中の研究の重要な分野です。 解釈可能性を高めることは、トラブルシューティングやモデルの改良に役立つだけでなく、AI システムの信頼性と透明性も強化します。

LLM モデルはどのようにトレーニングされますか?

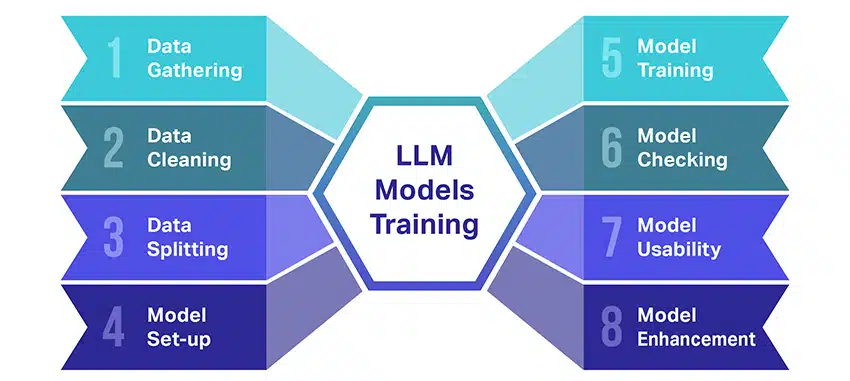

大規模言語モデル (LLM) のトレーニングは、いくつかの重要な手順を伴う非常に困難な作業です。 以下に、プロセスを段階的に簡単にまとめます。

- テキストデータの収集: LLM のトレーニングは、膨大な量のテキスト データの収集から始まります。 このデータは、書籍、Web サイト、記事、またはソーシャル メディア プラットフォームから取得することができます。 その目的は、人間の言語の豊かな多様性を捉えることです。

- データのクリーンアップ: 生のテキスト データは、前処理と呼ばれるプロセスで整理されます。 これには、不要な文字を削除する、テキストをトークンと呼ばれる小さな部分に分割する、すべてをモデルが使用できる形式に変換するなどのタスクが含まれます。

- データの分割: 次に、クリーンなデータが XNUMX つのセットに分割されます。 XNUMX つのセットであるトレーニング データは、モデルのトレーニングに使用されます。 もう XNUMX つのセットである検証データは、後でモデルのパフォーマンスをテストするために使用されます。

- モデルのセットアップ: 次に、アーキテクチャとして知られる LLM の構造が定義されます。 これには、ニューラル ネットワークの種類を選択し、ネットワーク内の層や隠れユニットの数などのさまざまなパラメーターを決定することが含まれます。

- モデルをトレーニングする: これから本格的な訓練が始まります。 LLM モデルは、トレーニング データを見て学習し、これまでに学習した内容に基づいて予測を行い、内部パラメーターを調整して予測と実際のデータの差異を小さくします。

- モデルの確認: LLM モデルの学習は検証データを使用してチェックされます。 これは、モデルのパフォーマンスがどの程度優れているかを確認し、パフォーマンスを向上させるためにモデルの設定を調整するのに役立ちます。

- モデルの使用: トレーニングと評価が完了すると、LLM モデルを使用できるようになります。 与えられた新しい入力に基づいてテキストを生成するアプリケーションやシステムに統合できるようになりました。

- モデルの改善: 最後に、常に改善の余地があります。 LLM モデルは、更新されたデータを使用したり、フィードバックや実際の使用状況に基づいて設定を調整したりすることで、時間の経過とともにさらに改良することができます。

このプロセスには、強力な処理装置や大容量ストレージなどの大量の計算リソースと、機械学習の専門知識が必要であることに注意してください。 そのため、通常は、必要なインフラストラクチャと専門知識にアクセスできる専門の研究組織または企業によって行われます。

LLM は教師あり学習と教師なし学習のどちらに依存しますか?

大規模な言語モデルは通常、教師あり学習と呼ばれる方法を使用してトレーニングされます。 簡単に言えば、これは、正解を示す例から学ぶことを意味します。

したがって、LLM に文を与えると、LLM は例から学んだことに基づいて次の単語またはフレーズを予測しようとします。 このようにして、意味があり、コンテキストに適合するテキストを生成する方法を学習します。

そうは言っても、LLM は教師なし学習を少し使用することもあります。 これは、子供にさまざまなおもちゃでいっぱいの部屋を探索させ、それらについて自分で学ばせるようなものです。 モデルは、「正しい」答えを教えられることなく、ラベルのないデータ、学習パターン、構造を調べます。

教師あり学習は、ラベル付き出力データを使用しない教師なし学習とは対照的に、入力と出力でラベル付けされたデータを使用します。

一言で言えば、LLM は主に教師あり学習を使用してトレーニングされますが、探索的分析や次元削減などの機能を強化するために教師なし学習を使用することもできます。

大規模な言語モデルをトレーニングするために必要なデータ量 (GB) はどれくらいですか?

音声データ認識と音声アプリケーションの可能性の世界は広大であり、それらは多くのアプリケーションのためにいくつかの業界で使用されています。

大規模な言語モデルのトレーニングは、特に必要なデータに関しては、万能のプロセスではありません。 それは多くのことに依存します。

- モデルのデザインです。

- どのような仕事をする必要があるのでしょうか?

- 使用しているデータの種類。

- どの程度のパフォーマンスを発揮したいですか?

とはいえ、LLM のトレーニングには通常、大量のテキスト データが必要です。 しかし、私たちはどれくらいの規模のことを話しているのでしょうか? そうですね、ギガバイト (GB) をはるかに超えて考えてください。 私たちは通常、テラバイト (TB) またはペタバイト (PB) 規模のデータを検討しています。

最大の LLM の 3 つである GPT-XNUMX を考えてみましょう。 で訓練されています 570GBのテキストデータ。 小規模な LLM では、必要な容量は少なくなり、おそらく 10 ~ 20 GB、あるいは 1 GB のギガバイトで済むかもしれませんが、それでもかなりの量です。

しかし、それはデータのサイズだけではありません。 品質も重要です。 モデルが効果的に学習できるように、データはクリーンで多様である必要があります。 また、必要なコンピューティング能力、トレーニングに使用するアルゴリズム、使用しているハードウェア設定など、パズルの他の重要な部分を忘れることはできません。 これらすべての要素が LLM のトレーニングに大きな役割を果たします。

大規模言語モデルの台頭: なぜそれが重要なのか

LLM はもはや単なる概念や実験ではありません。 私たちのデジタル環境において、それらはますます重要な役割を果たしています。 しかし、なぜこのようなことが起こっているのでしょうか? これらの LLM はなぜそれほど重要なのでしょうか? いくつかの重要な要素を詳しく見てみましょう。

人間のテキストを模倣することに熟達する

LLM は、言語ベースのタスクの処理方法を変革しました。 これらのモデルは、堅牢な機械学習アルゴリズムを使用して構築されており、文脈、感情、さらには皮肉を含む人間の言語のニュアンスをある程度理解する能力を備えています。 人間の言語を模倣するこの能力は単なる目新しいものではなく、重要な意味を持っています。

LLM の高度なテキスト生成機能により、コンテンツの作成から顧客サービスのやり取りに至るまで、あらゆるものを強化できます。

デジタル アシスタントに複雑な質問をして、理にかなっているだけでなく、一貫性と関連性があり、会話のような口調で答えられる答えが得られることを想像してみてください。 それが LLM によって可能になるのです。 これらは、より直観的で魅力的な人間と機械の対話を促進し、ユーザー エクスペリエンスを豊かにし、情報へのアクセスを民主化します。

手頃なコンピューティング能力

LLM の台頭は、コンピューティング分野での並行した開発がなければ不可能でした。 より具体的には、計算リソースの民主化は、LLM の進化と導入において重要な役割を果たしてきました。

クラウドベースのプラットフォームは、ハイパフォーマンス コンピューティング リソースへの前例のないアクセスを提供します。 このようにして、小規模な組織や独立した研究者でも、洗練された機械学習モデルをトレーニングできます。

さらに、処理装置 (GPU や TPU など) の改善と分散コンピューティングの台頭により、数十億のパラメーターを使用してモデルをトレーニングすることが可能になりました。 このコンピューティング能力へのアクセスのしやすさの向上により、LLM の成長と成功が可能になり、現場でのさらなるイノベーションとアプリケーションにつながります。

消費者の嗜好の変化

今日の消費者は単に答えを求めているわけではありません。 彼らは魅力的で共感できるやり取りを望んでいます。 デジタル テクノロジーを使用して成長する人が増えるにつれ、より自然で人間らしく感じられるテクノロジーへのニーズが高まっていることは明らかです。LLM は、これらの期待に応える比類のない機会を提供します。 これらのモデルは、人間のようなテキストを生成することで、魅力的でダイナミックなデジタル エクスペリエンスを作成し、ユーザーの満足度とロイヤリティを向上させることができます。 顧客サービスを提供する AI チャットボットであっても、ニュース更新を提供する音声アシスタントであっても、LLM は私たちをよりよく理解する AI の時代の到来をもたらします。

非構造化データの宝庫

電子メール、ソーシャル メディアの投稿、顧客レビューなどの非構造化データは、洞察の宝庫です。 以上であると推定されています 視聴者の38%が 企業データの一部は構造化されておらず、急速に増加しています 視聴者の38%が XNUMX年当たり。 このデータは、適切に活用すればビジネスにとって宝の山です。

ここでは、そのようなデータを大規模に処理して理解する能力を備えた LLM が活躍します。 感情分析、テキスト分類、情報抽出などのタスクを処理できるため、貴重な洞察が得られます。

ソーシャル メディアの投稿から傾向を特定する場合でも、レビューから顧客感情を測定する場合でも、LLM は企業が大量の非構造化データを操作し、データに基づいた意思決定を行うのを支援します。

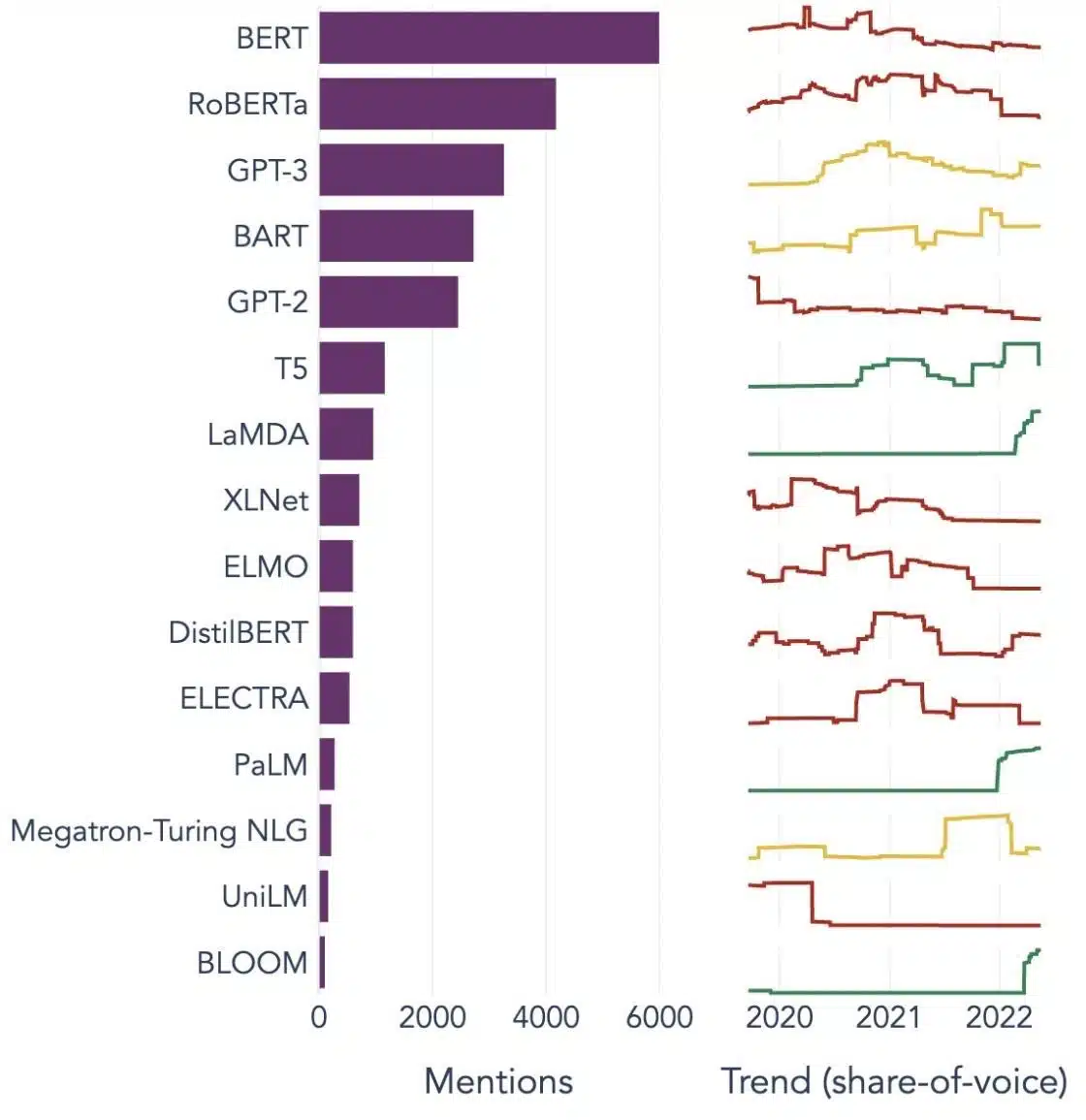

拡大するNLP市場

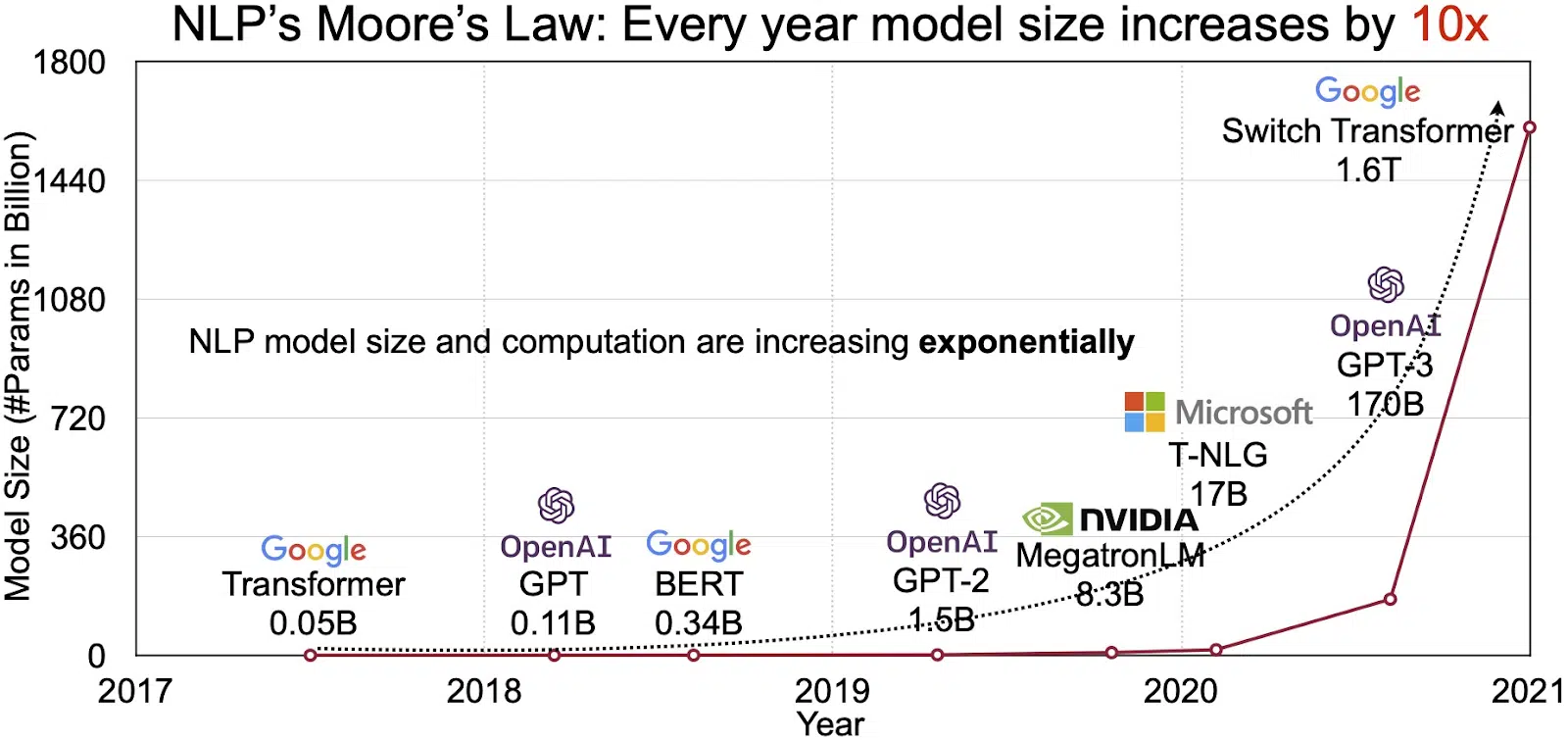

LLM の可能性は、急速に成長する自然言語処理 (NLP) 市場に反映されています。 アナリストは、NLP 市場が今後拡大すると予測しています。 11 年に 2020 億ドル、35 年までに 2026 億ドル以上。 しかし、拡大しているのは市場規模だけではありません。 モデル自体も、物理的なサイズと処理するパラメーターの数の両方で増加しています。 以下の図 (画像出典: リンク) に見られるように、長年にわたる LLM の進化は、LLM の複雑さと容量の増大を強調しています。

大規模言語モデルの一般的な使用例

以下は、LLM の最も一般的な使用例の一部です。

- 自然言語テキストの生成: 大規模言語モデル (LLM) は、人工知能と計算言語学の能力を組み合わせて、自然言語でテキストを自律的に生成します。 記事を書いたり、曲を作成したり、ユーザーと会話したりするなど、さまざまなユーザーのニーズに応えることができます。

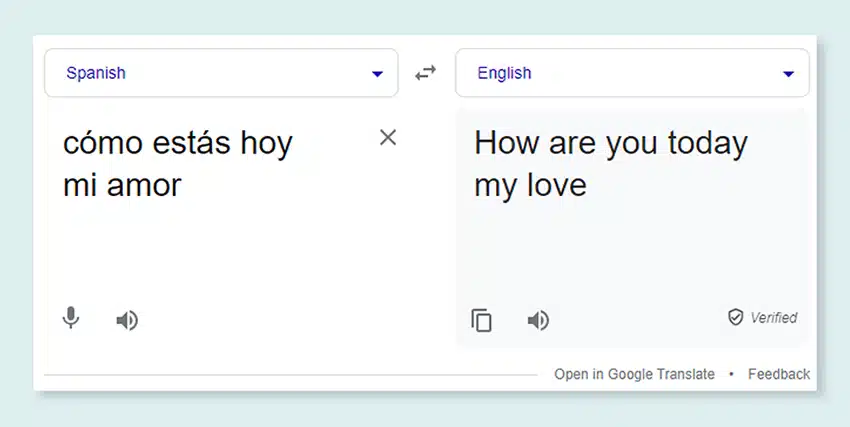

- 機械による翻訳: LLM を効果的に使用すると、任意の言語ペア間でテキストを翻訳できます。 これらのモデルは、リカレント ニューラル ネットワークなどの深層学習アルゴリズムを活用して、ソース言語とターゲット言語の両方の言語構造を理解することで、ソース テキストから目的の言語への翻訳を容易にします。

- オリジナルコンテンツの作成: LLM は、マシンが一貫性のある論理的なコンテンツを生成するための道を開きました。 このコンテンツは、ブログ投稿、記事、その他の種類のコンテンツの作成に使用できます。 モデルは、深い深層学習の経験を活用して、斬新でユーザーフレンドリーな方法でコンテンツをフォーマットおよび構造化します。

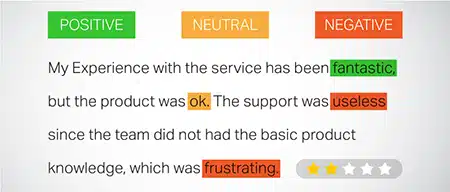

- 感情の分析: 大規模言語モデルの興味深い応用例の XNUMX つは感情分析です。 この場合、モデルは、注釈付きテキストに存在する感情状態とセンチメントを認識して分類するようにトレーニングされます。 このソフトウェアは、ポジティブ、ネガティブ、中立、その他の複雑な感情などの感情を識別できます。 これにより、さまざまな製品やサービスに関する顧客のフィードバックや意見に関する貴重な洞察が得られます。

- テキストの理解、要約、分類: LLM は、AI ソフトウェアがテキストとそのコンテキストを解釈するための実行可能な構造を確立します。 LLM は、膨大な量のデータを理解して精査するようにモデルに指示することで、AI モデルがさまざまな形式やパターンのテキストを理解、要約し、さらには分類できるようにします。

- 質問への回答: 大規模言語モデルは、質問応答 (QA) システムに、ユーザーの自然言語クエリを正確に認識して応答する機能を備えています。 このユースケースの一般的な例としては、ChatGPT や BERT が挙げられます。これらは、クエリのコンテキストを調べ、膨大なテキストのコレクションを選別して、ユーザーの質問に関連する応答を提供します。

セキュリティとコンプライアンスを LLM データ戦略に統合する

LLM データ収集および処理フレームワーク内に堅牢なセキュリティおよびコンプライアンスの対策を組み込むと、データの透明性、安全性、倫理的な使用を確保できます。このアプローチには、いくつかの重要なアクションが含まれます。

- 堅牢な暗号化を実装する: 強力な暗号化方式を使用して、保存中および転送中のデータを保護します。このステップにより、情報が不正アクセスや侵害から保護されます。

- アクセス制御と認証を確立する: ユーザーの身元を確認し、データへのアクセスを制限するシステムを設定します。これにより、許可された担当者のみが機密情報を操作できるようになります。

- ログ記録システムと監視システムを統合する: システムを導入してデータの使用状況を追跡し、潜在的なセキュリティ脅威を特定します。このプロアクティブな監視は、データ エコシステムの整合性と安全性の維持に役立ちます。

- コンプライアンス基準の遵守: データのセキュリティとプライバシーを管理する GDPR、HIPAA、PCI DSS などの関連規制に従います。定期的な監査とチェックによりコンプライアンスが検証され、業務が業界固有の法的および倫理的基準を確実に満たしていることが確認されます。

- 倫理的なデータ使用ガイドラインを設定する: データの公正、透明性、責任ある使用を規定するポリシーを策定し、施行します。これらのガイドラインは、関係者の信頼を維持し、LLM の安全なトレーニング環境をサポートするのに役立ちます。

これらのアクションにより、LLM トレーニングのデータ管理実践が強化されます。これにより、関係するすべての利害関係者に利益をもたらす信頼とセキュリティの基盤が構築されます。

大規模な言語モデルの微調整

大規模な言語モデルを微調整するには、綿密な注釈プロセスが必要です。 この分野の専門知識を持つ Shaip は、この取り組みを大きく支援します。 ChatGPT などのモデルをトレーニングするために使用されるいくつかのアノテーション方法を次に示します。

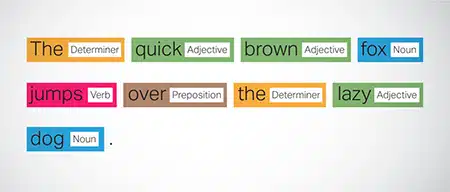

品詞 (POS) タグ付け

文内の単語には、動詞、名詞、形容詞などの文法機能がタグ付けされています。このプロセスは、モデルが文法と単語間のつながりを理解するのに役立ちます。

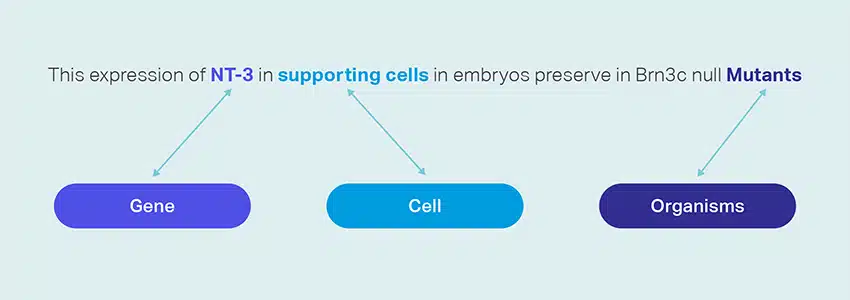

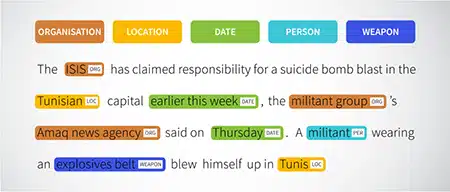

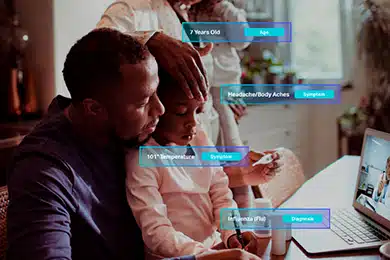

固有表現抽出(NER)

文内の組織、場所、人物などの名前付きエンティティがマークされます。 この演習は、モデルが単語やフレーズの意味論的な意味を解釈するのに役立ち、より正確な応答を提供します。

感情分析

テキスト データにはポジティブ、ニュートラル、ネガティブなどのセンチメント ラベルが割り当てられており、モデルが文章の感情的な基調を把握するのに役立ちます。 これは、感情や意見を含む質問に応答する場合に特に役立ちます。

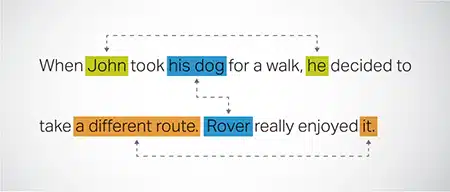

相互参照の解像度

テキストの異なる部分で同じエンティティが参照されているインスタンスを特定して解決します。 このステップは、モデルが文のコンテキストを理解するのに役立ち、一貫した応答につながります。

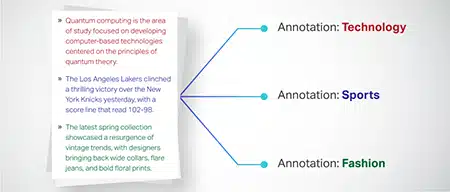

テキスト分類

テキスト データは、製品レビューやニュース記事などの事前定義されたグループに分類されます。 これは、モデルがテキストのジャンルやトピックを識別し、より適切な応答を生成するのに役立ちます。

シャイプ Web クローリングを通じて、銀行、保険、小売、通信などのさまざまなセクターからトレーニング データを収集できます。 テキストアノテーション(NER、センチメント分析など)を提供し、多言語LLM(翻訳)を促進し、タクソノミーの作成、抽出/迅速なエンジニアリングを支援します。

Shaip には、既製のデータセットの広範なリポジトリがあります。 当社の医療データ カタログには、AI イニシアチブ、機械学習モデル、自然言語処理に適した、匿名化された安全で高品質なデータの幅広いコレクションが含まれています。

同様に、当社の音声データ カタログは、音声認識製品に最適な高品質データの宝庫であり、AI/ML モデルの効率的なトレーニングを可能にします。 また、さまざまなアプリケーション向けの幅広い画像およびビデオ データを含む、優れたコンピューター ビジョン データ カタログもあります。

AI および ML プロジェクトで使用できる、変更可能で便利な形式のオープン データセットも無料で提供します。 この膨大な AI データ ライブラリにより、AI および ML モデルをより効率的かつ正確に開発できるようになります。

Shaip のデータ収集と注釈のプロセス

データの収集と注釈に関して言えば、 シャイプ 合理化されたワークフローに従います。 データ収集プロセスは次のようになります。

ソース Web サイトの特定

最初に、必要なデータに関連する選択されたソースとキーワードを使用して Web サイトが特定されます。

Webスクレイピング

関連する Web サイトが特定されると、Shaip は独自のツールを利用してこれらのサイトからデータを収集します。

テキストの前処理

収集されたデータは、文の分割や解析などの初期処理を受け、その後のステップに適したものになります。

アノテーション

前処理されたデータには、名前付きエンティティ抽出の注釈が付けられます。 このプロセスには、人、組織、場所などの名前など、テキスト内の重要な要素を特定してラベルを付けることが含まれます。

関係性の抽出

最後のステップでは、識別されたエンティティ間の関係のタイプが決定され、それに応じて注釈が付けられます。 これは、テキストのさまざまなコンポーネント間の意味上のつながりを理解するのに役立ちます。

シャイプの捧げもの

シャイプ は、組織がデータを管理、分析し、最大限に活用できるよう支援する幅広いサービスを提供しています。

データWebスクレイピング

Shaip が提供する主要なサービスの XNUMX つはデータ スクレイピングです。 これには、ドメイン固有の URL からのデータの抽出が含まれます。 Shaip は、自動化されたツールと技術を活用することで、さまざまな Web サイト、製品マニュアル、技術文書、オンライン フォーラム、オンライン レビュー、顧客サービス データ、業界規制文書などから大量のデータを迅速かつ効率的に収集できます。このプロセスは、次のような場合に企業にとって非常に貴重です。多数のソースから関連性のある具体的なデータを収集する。

機械翻訳

さまざまな言語間でテキストを翻訳するための、対応する文字起こしと組み合わせた広範な多言語データセットを使用してモデルを開発します。 このプロセスは、言語上の障害を取り除き、情報へのアクセスを促進します。

タクソノミーの抽出と作成

Shaip は分類法の抽出と作成に役立ちます。 これには、さまざまなデータ ポイント間の関係を反映する構造化された形式にデータを分類して分類することが含まれます。 これは、企業がデータを整理し、アクセスしやすく分析しやすくする場合に特に役立ちます。 たとえば、電子商取引ビジネスでは、製品データが製品タイプ、ブランド、価格などに基づいて分類され、顧客が製品カタログ内を簡単にナビゲートできるようになります。

データ収集

当社のデータ収集サービスは、生成 AI アルゴリズムのトレーニングとモデルの精度と有効性の向上に必要な重要な現実世界または合成データを提供します。 データは、データのプライバシーとセキュリティを念頭に置きながら、公平かつ倫理的かつ責任をもって調達されます。

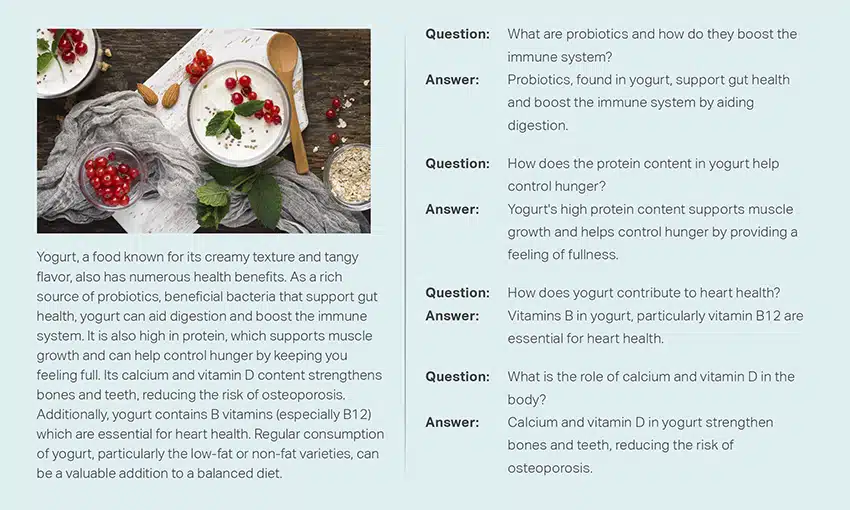

質疑応答

質問応答 (QA) は、人間の言語で質問に自動的に答えることに重点を置いた自然言語処理の下位分野です。 QA システムは広範なテキストとコードでトレーニングされており、事実、定義、意見に基づく質問など、さまざまな種類の質問を処理できます。 カスタマー サポート、ヘルスケア、サプライ チェーンなどの特定の分野に合わせた QA モデルを開発するには、ドメインの知識が不可欠です。 ただし、生成的 QA アプローチを使用すると、モデルはドメインの知識がなくても、コンテキストのみに依存してテキストを生成できます。

当社の専門家チームは、包括的な文書やマニュアルを注意深く調査して質問と回答のペアを生成し、企業向けの生成 AI の作成を促進します。 このアプローチでは、広範なコーパスから関連情報をマイニングすることで、ユーザーの問い合わせに効果的に対処できます。 当社の認定専門家は、さまざまなトピックや分野にわたる最高品質の Q&A ペアの作成を保証します。

テキストの要約

当社のスペシャリストは、包括的な会話や長い対話を抽出し、広範なテキスト データから簡潔で洞察力に富んだ要約を提供することができます。

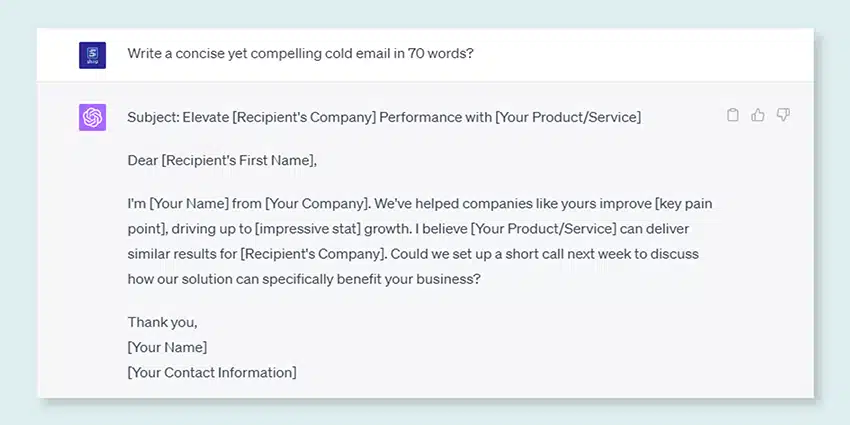

テキスト生成

ニュース記事、フィクション、詩など、さまざまなスタイルのテキストの広範なデータセットを使用してモデルをトレーニングします。 これらのモデルは、ニュース記事、ブログ エントリ、ソーシャル メディア投稿などのさまざまな種類のコンテンツを生成でき、コンテンツ作成のための費用対効果が高く、時間を節約できるソリューションを提供します。

音声認識

さまざまなアプリケーション向けに音声言語を理解できるモデルを開発します。 これには、音声起動アシスタント、ディクテーション ソフトウェア、リアルタイム翻訳ツールが含まれます。 このプロセスには、対応するトランスクリプトと組み合わせた、話し言葉の音声録音で構成される包括的なデータセットの利用が含まれます。

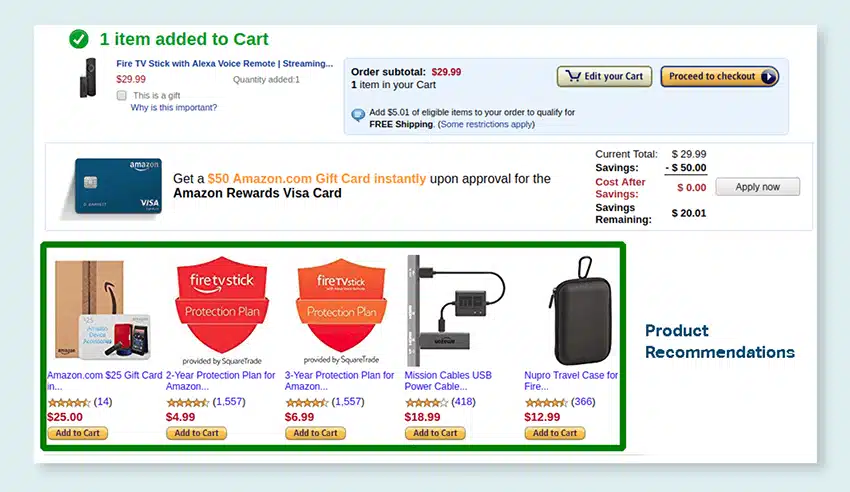

製品の推奨事項

顧客が購入する傾向にある製品を示すラベルなど、顧客の購入履歴の広範なデータセットを使用してモデルを開発します。 お客様へ的確な提案を行い、売上の向上と顧客満足度の向上を目指します。

画像のキャプション

最先端の AI 主導の画像キャプション サービスで、画像解釈プロセスに革命をもたらします。 私たちは、正確で文脈的に意味のある説明を作成することで、写真に活力を吹き込みます。 これにより、視聴者にとってビジュアル コンテンツとの革新的なエンゲージメントとインタラクションの可能性への道が開かれます。

テキスト読み上げサービスのトレーニング

AI モデルのトレーニングに最適な、人間の音声録音で構成される広範なデータセットを提供します。 これらのモデルは、アプリケーション向けに自然で魅力的な音声を生成できるため、ユーザーに独特で臨場感のあるサウンド エクスペリエンスを提供します。

当社の多様なデータ カタログは、多数の生成 AI ユースケースに対応できるように設計されています

既製の医療データカタログとライセンス:

- 5の専門分野の31万以上のレコードと医師のオーディオファイル

- 放射線科およびその他の専門分野(MRI、CT、USG、XR)の2万以上の医用画像

- 付加価値エンティティと関係アノテーションを備えた30k以上の臨床テキストドキュメント

既製の音声データカタログとライセンス:

- 40k時間以上の音声データ(50以上の言語/ 100以上の方言)

- 55以上のトピックがカバーされています

- サンプリングレート– 8/16/44/48 kHz

- 音声の種類 - 自発的、スクリプト化された、モノローグ、ウェイクアップ ワード

- 人間と人間の会話、人間とボット、人間とエージェントのコールセンターでの会話、モノローグ、スピーチ、ポッドキャストなどを複数の言語で完全に文字起こしした音声データセット。

画像およびビデオデータのカタログとライセンス:

- 食品/ドキュメント画像コレクション

- ホームセキュリティビデオコレクション

- 顔の画像/ビデオコレクション

- 請求書、PO、OCRの領収書ドキュメントコレクション

- 車両損傷検出のための画像収集

- 車両のナンバープレート画像コレクション

- 車内画像コレクション

- 車のドライバーに焦点を当てた画像コレクション

- ファッション関連の画像集

話しましょう

よくある質問(FAQ)

DL は、複数の層を持つ人工ニューラル ネットワークを利用してデータの複雑なパターンを学習する ML のサブフィールドです。 ML は、機械がデータから学習できるようにするアルゴリズムとモデルに焦点を当てた AI のサブセットです。 大規模言語モデル (LLM) はディープ ラーニングのサブセットであり、生成 AI と共通点を持っています。どちらもディープ ラーニングのより広範な分野のコンポーネントであるためです。

大規模言語モデル (LLM) は、言語の基本的な側面を把握するために、最初に広範なテキスト データで事前トレーニングされた拡張的で汎用性の高い言語モデルです。 その後、特定のアプリケーションやタスクに合わせて微調整され、特定の目的に合わせて適応および最適化できるようになります。

まず、大規模な言語モデルは、大量のデータと数十億のパラメーターを使用した広範なトレーニングにより、幅広いタスクを処理する能力を備えています。

第二に、これらのモデルは最小限の特定のフィールド トレーニング データで微調整できるため、適応性を示します。

最後に、LLM のパフォーマンスは、追加のデータとパラメーターが組み込まれると継続的に向上し、時間の経過とともにその有効性が向上します。

プロンプトの設計には、翻訳タスクで必要な出力言語を指定するなど、特定のタスクに合わせたプロンプトの作成が含まれます。 一方、プロンプト エンジニアリングでは、ドメインの知識を組み込んだり、出力例を提供したり、効果的なキーワードを使用したりして、パフォーマンスを最適化することに重点を置きます。 プロンプト デザインは一般的な概念ですが、プロンプト エンジニアリングは特殊なアプローチです。 すべてのシステムには迅速な設計が不可欠ですが、高い精度やパフォーマンスが必要なシステムには迅速なエンジニアリングが重要になります。

大規模な言語モデルには XNUMX つのタイプがあります。 タイプごとに、プロモーションには異なるアプローチが必要です。

- 汎用言語モデルは、トレーニング データ内の言語に基づいて次の単語を予測します。

- 命令調整モデルは、入力で与えられた命令に対する応答を予測するようにトレーニングされます。

- 対話調整モデルは、次の応答を生成することで対話のような会話を行うようにトレーニングされます。