機械学習におけるトレーニング データとは:

定義、利点、課題、例、データセット

究極のバイヤーガイド2023

概要

人工知能と機械学習の世界では、データトレーニングは避けられません。 これは、機械学習モジュールを正確、効率的、完全に機能させるプロセスです。 この投稿では、AIトレーニングデータとは何か、トレーニングデータの品質、データの収集とライセンスなどについて詳しく説明します。

平均して、成人は過去の学習に基づいて人生や日常のことを決定すると推定されています。 これらは、順番に、状況や人々によって形作られた人生経験から来ています。 文字通りの意味では、状況、インスタンス、および人々は、私たちの心に与えられるデータに他なりません。 私たちが長年のデータを経験の形で蓄積するにつれて、人間の心はシームレスな決定を下す傾向があります。

これは何を伝えますか? そのデータは学習において避けられません。

子供がA、B、C、Dの文字を理解するためにアルファベットと呼ばれるラベルを必要とするのと同様に、機械も受信するデータを理解する必要があります。

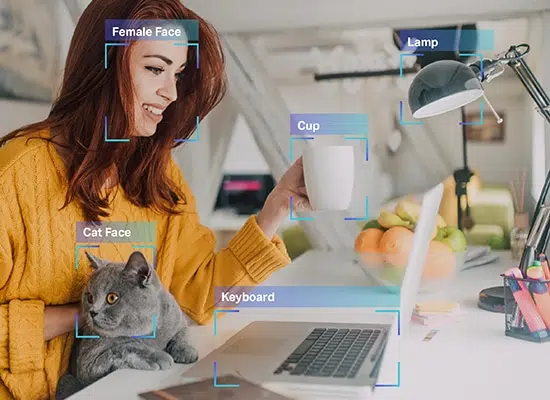

それがまさに 人工知能(AI) トレーニングがすべてです。 機械は、教えようとしていることからまだ物事を学んでいない子供と何ら変わりはありません。 猫と犬、バスと車を区別するための機械は、それらのアイテムをまだ体験していないか、どのように見えるかを教えられていないため、わかりません。

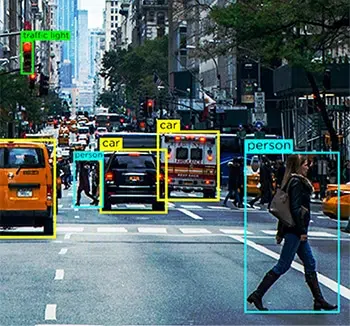

したがって、自動運転車を製造する人にとって、追加する必要のある主な機能は、車が遭遇する可能性のあるすべての日常的な要素を理解するシステムの機能です。これにより、車両はそれらを識別し、適切な運転決定を行うことができます。 これはどこです AIトレーニングデータ 戦場に出ます。

今日、人工知能モジュールは、レコメンデーションエンジン、ナビゲーション、自動化などの形で多くの便利さを提供してくれます。 これらはすべて、アルゴリズムの構築中にアルゴリズムをトレーニングするために使用されたAIデータトレーニングが原因で発生します。

AIトレーニングデータは、構築の基本的なプロセスです 機械学習 およびAIアルゴリズム。 これらの技術概念に基づいたアプリを開発している場合は、最適化された処理のためにデータ要素を理解するようにシステムをトレーニングする必要があります。 トレーニングがないと、AIモデルは非効率になり、欠陥があり、無意味になる可能性があります。

データサイエンティストは 時間の80% MLモデルをトレーニングするためのデータ準備と強化。

そのため、ベンチャーキャピタリスト、野心的なプロジェクトに取り組んでいるソロプレナー、高度なAIを始めたばかりの技術愛好家から資金を調達したいと考えている方のために、このガイドを作成して、 AIトレーニングデータ。

ここでは、AIトレーニングデータとは何か、プロセスでそれが避けられない理由、実際に必要なデータの量と質などについて説明します。

AIトレーニングデータとは何ですか?

AI トレーニング データは、トレーニング目的でシステムに供給される、慎重にキュレーションおよびクリーニングされた情報です。 このプロセスは、AI モデルの成功を左右します。 画像内の XNUMX 本足の動物がすべて犬であるとは限らないという理解を深めるのに役立ちます。また、モデルが怒りの叫びと喜びに満ちた笑いを区別するのに役立ちます。 これは、機械に基本を教え、より多くのデータが供給されるにつれて機械が学習できるようにするためにスプーン供給データを必要とする人工知能モジュールを構築する最初の段階です。 これもまた、正確な結果をエンド ユーザーに大量に提供する効率的なモジュールに道を譲ります。

AI トレーニング データ プロセスをミュージシャンの練習セッションと考えてください。練習すればするほど、歌や音階が上達します。 ここでの唯一の違いは、最初に楽器とは何かを機械に教えなければならないということです。 ミュージシャンがステージで数え切れないほどの時間を練習に費やしているように、AI モデルを展開すると消費者に最適な体験を提供します。

AIトレーニングデータが必要なのはなぜですか?

モデルの開発にAIトレーニングデータが必要な理由に対する最も簡単な答えは、AIトレーニングデータがないと、マシンはそもそも何を理解すべきかさえわからないということです。 特定の仕事のために訓練された個人のように、機械は特定の目的を果たし、対応する結果を提供するために情報のコーパスを必要とします。

自動運転車の例をもう一度考えてみましょう。 自動運転車のテラバイト後のデータは、複数のセンサー、コンピュータービジョンデバイス、レーダー、LIDARなどから取得されます。 車の中央処理システムがそれをどう処理するかを知らなければ、これらの大量のデータはすべて無意味です。

例えば、 コンピュータビジョン 車のユニットは、歩行者、動物、くぼみなどの道路要素に関する大量のデータを吐き出している可能性があります。 機械学習モジュールがそれらを識別するように訓練されていない場合、車両は、それらが遭遇した場合に事故を引き起こす可能性のある障害であることを認識しません。 そのため、モジュールは、道路のすべての要素が何であるか、および各要素に異なる運転決定がどのように必要であるかについてトレーニングする必要があります。

これは視覚的な要素のためだけですが、車は人間の指示を理解できる必要があります 自然言語処理(NLP) & オーディオまたはスピーチコレクション それに応じて対応します。 たとえば、ドライバーが車載インフォテインメントシステムに近くのガソリンスタンドを探すように命令した場合、ドライバーは要件を理解して適切な結果を出すことができるはずです。 ただし、そのためには、フレーズ内のすべての単語を理解し、それらを接続して、質問を理解できる必要があります。

AIトレーニングデータのプロセスは、自動運転車などの重いユースケースに展開されているために複雑であるかどうか疑問に思うかもしれませんが、Netflixが推奨する次の映画でも、パーソナライズされた提案を提供するために同じプロセスを実行することをお勧めします。 AIが関連付けられているアプリ、プラットフォーム、またはエンティティは、デフォルトでAIトレーニングデータを利用しています。

どのような種類のデータが必要ですか?

機械学習モデルを効果的にトレーニングするために必要となるデータには、画像、ビデオ、音声/音声、テキストの4つの主要なタイプがあります。 必要なデータの種類は、手元のユースケース、トレーニングするモデルの複雑さ、使用するトレーニング方法、必要な入力データの多様性など、さまざまな要因によって異なります。

どのくらいのデータが適切ですか?

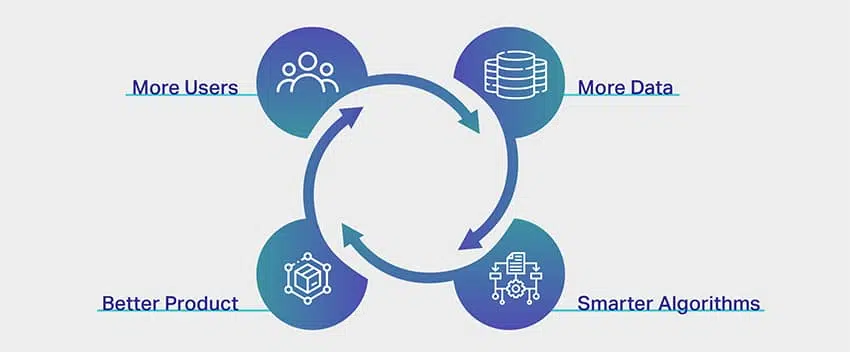

彼らは、学習に終わりはなく、このフレーズはAIトレーニングデータスペクトルにおいて理想的であると言います。 データが多いほど、結果は良くなります。 ただし、これほど漠然とした応答では、AIを利用したアプリの起動を検討している人を納得させるには不十分です。 しかし現実には、AIデータセットをトレーニングするために必要なデータの正確な量の一般的な経験則、式、インデックス、または測定値はありません。

機械学習の専門家は、プロジェクトに必要なデータの量を推測するために、別のアルゴリズムまたはモジュールを構築する必要があることをコミカルに明らかにします。 それは悲しいことに現実でもあります。

さて、AIトレーニングに必要なデータ量に上限を設けることが非常に難しいのには理由があります。 これは、トレーニングプロセス自体に伴う複雑さのためです。 AIモジュールは、相互に関連し、重なり合うフラグメントのいくつかのレイヤーで構成されており、互いのプロセスに影響を与え、補完します。

たとえば、ココナッツの木を認識する簡単なアプリを開発しているとしましょう。 見た目からすると、かなりシンプルに聞こえますよね? ただし、AIの観点からは、はるかに複雑です。

最初は、マシンは空です。 そもそも、背の高い、地域固有のトロピカルフルーツを生む木は言うまでもなく、木が何であるかはわかりません。 そのためには、モデルは、木が何であるか、街灯や電柱などのフレームに表示される可能性のある他の高くて細いオブジェクトと区別する方法についてトレーニングし、次にココナッツの木のニュアンスを教える必要があります。 機械学習モジュールがココナッツの木とは何かを学習すると、ココナッツの木を認識する方法を知っていると安全に推測できます。

しかし、ガジュマルの木の画像をフィードした場合にのみ、システムがガジュマルの木をココナッツの木と誤認していることに気付くでしょう。 システムの場合、葉が密集している背の高いものはすべてココナッツの木です。 これを排除するために、システムはココナッツの木ではないすべての木を正確に識別するために理解する必要があります。 これが、結果がXNUMXつしかない単純な一方向アプリのプロセスである場合、ヘルスケア、金融などのために開発されたアプリに伴う複雑さを想像することしかできません。

これとは別に、必要なデータの量にも影響を与えるもの トレーニングには、以下の側面が含まれます。

- データ型の違い(構造化)のトレーニング方法 および非構造化)大量のデータの必要性に影響を与える

- データのラベル付け または注釈技術

- データがシステムに供給される方法

- エラー許容度の商、これは単にのパーセンテージを意味します あなたのニッチまたはドメインで無視できるエラー

トレーニングボリュームの実際の例

モジュールをトレーニングするために必要なデータの量は異なりますが あなたのプロジェクトと私たちが以前に議論した他の要因について、少し インスピレーションや参考資料は、データに関する広範なアイデアを得るのに役立ちます 要件。

以下は、使用されるデータセットの量の実際の例です さまざまな企業や企業によるAIトレーニングの目的で。

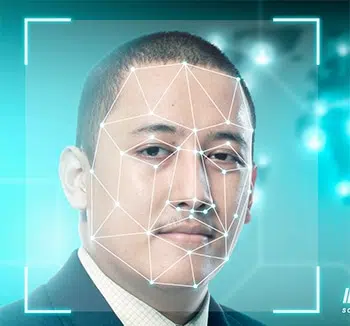

- 顔認識 –450,000を超える顔画像のサンプルサイズ

- 画像注釈 –185,000を超える画像のサンプルサイズ 650,000近くの注釈付きオブジェクト

- Facebookの感情分析 –サンプルサイズが9,000を超える コメントと62,000件の投稿

- チャットボットトレーニング –サンプルサイズが200,000を超える質問 2万以上の回答

- 翻訳アプリ –300,000を超える音声または音声のサンプルサイズ 非ネイティブスピーカーからのコレクション

十分なデータがない場合はどうなりますか?

AIとMLの世界では、データトレーニングは避けられません。 新しいことを学ぶことに終わりはないと正しく言われていますが、これはAIトレーニングデータスペクトルについて話すときに当てはまります。 データが多いほど、結果は良くなります。 ただし、解決しようとしているユースケースがニッチなカテゴリに関連している場合があり、適切なデータセット自体を調達することが課題になります。 したがって、このシナリオでは、適切なデータがない場合、MLモデルからの予測が正確でないか、偏っている可能性があります。 欠点を克服するのに役立つデータ拡張やデータマークアップなどの方法がありますが、それでも結果は正確または信頼できない場合があります。

データ品質をどのように改善しますか?

データの品質は、出力の品質に正比例します。 そのため、高精度のモデルでは、トレーニングに高品質のデータセットが必要です。 ただし、落とし穴があります。 精度と正確さに依存する概念の場合、品質の概念はしばしばかなり曖昧です。

高品質のデータは強力で信頼できるように聞こえますが、実際にはどういう意味ですか?

そもそも品質とは?

私たちがシステムに提供するデータそのものと同様に、品質にも多くの要因とパラメーターが関連付けられています。 AIの専門家や機械学習のベテランに連絡すると、高品質のデータの順列を共有する可能性があります。

- 均一の – XNUMXつの特定のソースから供給されたデータ、または複数のソースから供給されたデータセットの均一性

- 包括的な –システムが取り組むことを意図しているすべての可能なシナリオをカバーするデータ

- 一貫性のある –データのすべてのバイトは本質的に類似しています

- 関連性 –ソースおよびフィードするデータは、要件および期待される結果と類似しており、

- 雑多 –オーディオ、ビデオ、画像、テキストなど、あらゆる種類のデータの組み合わせがあります

データ品質の品質が何を意味するかを理解したので、品質を確保するためのさまざまな方法を簡単に見てみましょう。 データ収集 と世代。

1. 構造化データと非構造化データに注意してください。 前者は、注釈付きの要素とメタデータがあるため、マシンで簡単に理解できます。 ただし、後者はまだ未加工であり、システムが利用できる貴重な情報はありません。 これがデータ注釈の出番です。

2. バイアスを排除することは、システムがシステムから偏見を取り除き、客観的な結果をもたらすため、品質データを保証するもうXNUMXつの方法です。 バイアスは結果を歪めるだけで無駄になります。

3. データを広範囲にクリーンアップすると、出力の品質が常に向上します。 データサイエンティストなら誰でも、彼らの仕事の大部分はデータをクリーンアップすることだと言うでしょう。 データをクリーンアップすると、重複、ノイズ、欠落値、構造エラーなどが削除されます。

トレーニングデータの品質に影響を与えるものは何ですか?

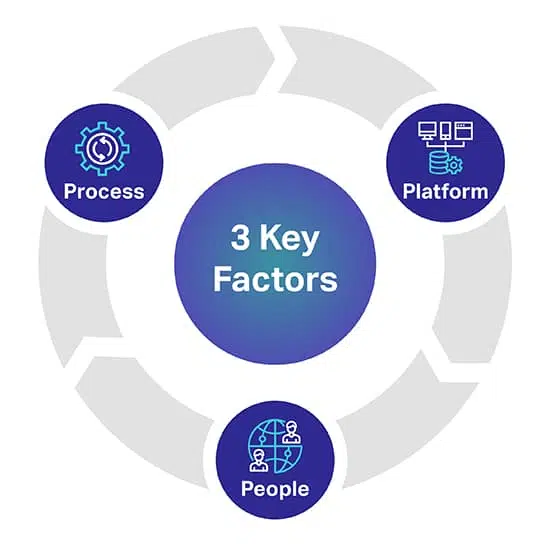

AI / MLモデルに求める品質のレベルを予測するのに役立つ3つの主な要因があります。 XNUMXつの重要な要素は、AIプロジェクトを成功または失敗させる可能性のある人、プロセス、およびプラットフォームです。

プラットフォーム: 最も要求の厳しいAIおよびMLイニシアチブを正常に展開するには、多様なデータセットを調達、転記、および注釈を付けるために、完全なヒューマンインザループ独自のプラットフォームが必要です。 プラットフォームは、ワーカーを管理し、品質とスループットを最大化する役割も果たします

人々: AIをよりスマートに考えるには、業界で最も賢い頭脳の一部である人々が必要です。 スケーリングするには、世界中の何千人ものこれらの専門家がすべてのデータ型を転記、ラベル付け、および注釈を付ける必要があります。

プロセス: 一貫性があり、完全で、正確なゴールドスタンダードのデータを提供することは複雑な作業です。 しかし、最高の品質基準と厳格で実績のある品質管理およびチェックポイントを順守するために、常に提供する必要があるものです。

AIトレーニングデータはどこから入手しますか?

前のセクションとは異なり、ここには非常に正確な洞察があります。 ソースデータをお探しの方へ

または、ビデオ収集、画像収集、テキスト収集などの過程にある場合は、XNUMXつあります

データを入手できる主要な手段。

それらを個別に調べてみましょう。

無料のソース

無料のソースは、大量のデータの非自発的なリポジトリである手段です。 ただ無料で表面に横たわっているだけのデータです。 無料のリソースには次のものがあります–

- 250年に2020億XNUMX万セット以上のデータがリリースされたGoogleデータセット

- Reddit、Quoraなどのフォーラム。これらはデータの豊富なソースです。 さらに、これらのフォーラムのデータサイエンスとAIコミュニティは、連絡があったときに特定のデータセットを支援することもできます。

- Kaggleは、無料のデータセットとは別に機械学習リソースを見つけることができるもうXNUMXつの無料のソースです。

- AIモデルのトレーニングを開始するための無料のオープンデータセットもリストされています

これらの手段は無料ですが、最終的に費やすのは時間と労力です。 無料のソースからのデータはいたるところにあり、ニーズに合わせてデータの調達、クリーニング、調整に何時間も費やす必要があります。

覚えておくべき他の重要なポイントのXNUMXつは、無料のソースからのデータの一部は商用目的にも使用できないということです。 必要です データライセンス.

データスクレイピング

名前が示すように、データスクレイピングは、適切なツールを使用して複数のソースからデータをマイニングするプロセスです。 ツールは、Webサイト、公開ポータル、プロファイル、ジャーナル、ドキュメントなどから、必要なデータをスクレイピングして、データベースにシームレスに取得できます。

これは理想的な解決策のように聞こえますが、データのスクレイピングは個人的な使用に関してのみ合法です。 商業的な野心を持ってデータをスクレイピングしようとしている企業の場合、それはトリッキーになり、違法にさえなります。 そのため、必要なデータを取得する前に、法務チームがWebサイト、コンプライアンス、および条件を調査する必要があります。

外部ベンダー

AIトレーニングデータのデータ収集に関する限り、データセットについて外部ベンダーにアウトソーシングまたは連絡することが最も理想的なオプションです。 モジュールの構築に集中できる一方で、要件に合ったデータセットを見つける責任があります。 これは特に次の理由によるものです–

- データの手段を探すのに何時間も費やす必要はありません

- データのクレンジングと分類に関する取り組みはありません

- しばらく前に説明したすべての要素を正確にチェックする品質データセットを手に入れます

- ニーズに合わせたデータセットを取得できます

- プロジェクトに必要な量のデータなどを要求できます

- そして最も重要なことは、データ収集とデータ自体が地域の規制ガイドラインに準拠していることも確認することです。

業務の規模によっては欠点となる可能性がある唯一の要因は、アウトソーシングには費用がかかることです。 繰り返しますが、費用を伴わないもの。

Shaipはすでにデータ収集サービスのリーダーであり、野心的なAIプロジェクトのライセンスを取得できるヘルスケアデータと音声/音声データセットの独自のリポジトリを持っています。

データセットを開く–使用するか使用しないか?

たとえば、142年から1996年までの2014億9万件を超えるユーザーレビューを特徴とするAmazon製品レビューデータセットがあります。画像については、2万件を超える写真からデータセットを入手できるGoogle OpenImagesのような優れたリソースがあります。 Googleには、XNUMX秒の長さのXNUMX万近くのオーディオクリップを提供するMachinePerceptionと呼ばれるウィングもあります。

これらのリソース(およびその他)が利用可能であるにもかかわらず、見過ごされがちな重要な要素は、それらの使用に伴う条件です。 それらは確かに公開されていますが、違反とフェアユースの間には細い線があります。 各リソースには独自の条件があり、これらのオプションを検討している場合は注意が必要です。 これは、無料の手段を好むという口実で、訴訟や関連費用が発生する可能性があるためです。

AIトレーニングデータの真のコスト

データを調達したり、社内でデータを生成したりするために費やすお金だけが、考慮すべきものではありません。 AIシステムの開発に費やされた時間や労力などの線形要素を考慮する必要があります。 コスト トランザクションの観点から。 他を褒めることに失敗します。

データの調達と注釈付けに費やされた時間

地理、市場の人口統計、ニッチ内の競争などの要因が、関連するデータセットの可用性を妨げています。 データを手動で検索するために費やされる時間は、AIシステムのトレーニングに時間を浪費します。 データを調達できたら、データに注釈を付けることに時間を費やしてトレーニングをさらに遅らせ、マシンがデータの供給内容を理解できるようにします。

データの収集と注釈付けの価格

AIデータを調達する際には、諸経費(社内データコレクター、アノテーター、機器の保守、技術インフラストラクチャ、SaaSツールのサブスクリプション、独自のアプリケーションの開発)を計算する必要があります。

悪いデータのコスト

悪いデータは、会社のチームの士気、競争力、および見過ごされてしまうその他の具体的な結果を犠牲にする可能性があります。 不良データとは、汚れた、生の、無関係な、時代遅れの、不正確な、またはスペルミスに満ちたデータセットと定義します。 悪いデータは、バイアスを導入し、歪んだ結果でアルゴリズムを破壊することにより、AIモデルを台無しにする可能性があります。

管理費

組織または企業、有形資産、および無形資産の管理に関連するすべてのコストは、非常に多くの場合最も高価な管理コストを構成します。

データソーシングの次は何ですか?

データセットを手に入れたら、次のステップはそれに注釈を付けるかラベルを付けることです。 すべての複雑なタスクの後、あなたが持っているのはクリーンな生データです。 注釈が付けられていないため、マシンはまだデータを理解できません。 ここから、実際の課題の残りの部分が始まります。

すでに述べたように、マシンには理解できる形式のデータが必要です。 これはまさにデータ注釈が行うことです。 生データを取得し、ラベルとタグのレイヤーを追加して、モジュールがデータ内のすべての要素を正確に理解できるようにします。

たとえば、テキストでは、データのラベル付けにより、AIシステムに文法構文、品詞、前置詞、句読点、感情、感情、および機械理解に関連するその他のパラメータが通知されます。 これは、チャットボットが人間の会話をよりよく理解する方法であり、それを理解した場合にのみ、応答を通じて人間の相互作用をよりよく模倣することができます。

必然的に聞こえますが、それは非常に時間と手間もかかります。 ビジネスの規模や野心に関係なく、データに注釈を付けるのにかかる時間は膨大です。

これは主に、データ注釈のスペシャリストがいない場合、既存の従業員がデータに注釈を付けるために毎日のスケジュールから時間を割く必要があるためです。 したがって、チームメンバーを召喚し、これを追加のタスクとして割り当てる必要があります。 遅延が長ければ長いほど、AIモデルのトレーニングに時間がかかります。

データ注釈用の無料のツールがありますが、それはこのプロセスに時間がかかるという事実を取り除くものではありません。

そこで、Shaipのようなデータ注釈ベンダーが登場します。彼らはデータ注釈スペシャリストの専任チームを招き、プロジェクトにのみ集中します。 彼らはあなたのニーズと要件にあなたが望む方法であなたに解決策を提供します。 その上、あなたは彼らと一緒に時間枠を設定し、その特定のタイムラインで完了するように作業を要求することができます。

主な利点のXNUMXつは、社内のチームメンバーが、専門家がデータに注釈を付けてラベルを付ける作業を行っている間、運用とプロジェクトにとってより重要なことに引き続き集中できることです。

アウトソーシングにより、最適な品質、最小限の時間、最高の精度を確保できます。

アップラッピング

AIトレーニングデータのすべてでした。 トレーニングデータとは何かを理解することから、無料のリソースとデータ注釈のアウトソーシングの利点を探求することまで、私たちはそれらすべてについて議論しました。 繰り返しになりますが、プロトコルとポリシーはこの範囲ではまだ不安定であり、ニーズに応じて、私たちのようなAIトレーニングデータの専門家に連絡することを常にお勧めします。

ソーシング、匿名化からデータ注釈まで、プラットフォームの構築にのみ取り組むことができるように、すべてのニーズに対応します。 私たちは、データの調達とラベリングに伴う複雑さを理解しています。 だからこそ、あなたが難しい仕事を私たちに任せて、私たちのソリューションを利用することができるという事実を繰り返します。

今日のすべてのデータ注釈のニーズについては、私たちに連絡してください。

話しましょう

よくある質問(FAQ)

インテリジェントシステムを作成する場合は、教師あり学習を促進するために、クリーンでキュレーションされた実用的な情報を入力する必要があります。 ラベル付けされた情報はAIトレーニングデータと呼ばれ、市場メタデータ、MLアルゴリズム、および意思決定に役立つすべてのもので構成されます。

すべてのAI搭載マシンには、その歴史的な根拠によって制限された機能があります。 つまり、マシンは、同等のデータセットを使用して以前にトレーニングされている場合にのみ、望ましい結果を予測できます。 トレーニングデータは、AIモデルの効率と精度に正比例する量の教師ありトレーニングに役立ちます。

AIを利用したセットアップがコンテキストを念頭に置いて重要な決定を下すのを支援するために、特定の機械学習アルゴリズムをトレーニングするには、異なるトレーニングデータセットが必要です。 たとえば、コンピュータビジョン機能をマシンに追加することを計画している場合、モデルは注釈付きの画像とより多くの市場データセットでトレーニングする必要があります。 同様に、NLPの能力については、大量の音声収集がトレーニングデータとして機能します。

有能なAIモデルをトレーニングするために必要なトレーニングデータの量に上限はありません。 データ量が多いほど、要素、テキスト、およびコンテキストを識別および分離するモデルの機能が向上します。

利用可能なデータはたくさんありますが、すべてのチャンクがモデルのトレーニングに適しているわけではありません。 アルゴリズムが最高の状態で機能するためには、包括的で一貫性のある関連性のあるデータセットが必要です。これらのデータセットは均一に抽出されますが、幅広いシナリオをカバーするのに十分な多様性があります。 データに関係なく、使用する予定がある場合は、学習を改善するために、同じものをクリーンアップして注釈を付けることをお勧めします。

特定のAIモデルを念頭に置いているが、トレーニングデータが十分でない場合は、最初に外れ値を削除し、転送と反復学習のセットアップをペアにして、機能を制限し、ユーザーがデータを追加し続けることができるようにセットアップをオープンソースにする必要があります。時間内に、徐々に、マシンをトレーニングします。 制限されたデータセットを最大限に活用するために、データ拡張と転送学習に関するアプローチに従うこともできます。

オープンデータセットは、トレーニングデータの収集にいつでも使用できます。 ただし、モデルをより適切にトレーニングするための独占権を求める場合は、外部ベンダー、Reddit、Kaggleなどの無料ソース、さらにはプロファイル、ポータル、ドキュメントから洞察を選択的にマイニングするためのデータスクレイピングに頼ることができます。 アプローチに関係なく、使用する前に、調達したデータをフォーマット、削減、およびクリーンアップする必要があります。